2. 复旦大学 哲学学院 上海 200433;

3. 中国科协—复旦大学科技伦理与人类未来研究院 上海 200433

2. School of Philosophy, Fudan University, Shanghai 200433, China;

3. Institute of Technology Ethics for Human Future, CAST-FDU, Shanghai 200433, China

人工智能大模型的快速发展引发了有关可持续发展的广泛讨论。已有研究从伦理治理、社会实验等多个角度对大模型带来的广泛影响展开前沿探索。随着大模型活动逐步从研发端向生态端发展,其带来的社会、经济、环境等多方面影响引起了学术界和产业界的高度关注,对大模型健康可持续发展形成整体性认识极为迫切。2023年4月,中共中央政治局会议强调,“要重视通用人工智能发展,营造创新生态,重视防范风险”。但目前从大模型的创新生态来看,中国的人工智能产业正在进入一场名副其实的“百模大战”,不仅面临研发层面的资源分散局面,同时也面临能源、环境和社会层面的诸多挑战。在当前国际社会积极推动企业ESG(环境—社会—治理)发展模式和中国政府面临“双碳”压力的背景下,如何合理布局人工智能大模型发展生态,推动大模型的健康与高质量可持续发展,成为亟待解决的任务。

1 ESG视角下人工智能大模型发展效益ESG是指包括环境(environment)、社会(society)和治理(governance)在内的因素,通常与道德或社会责任投资有关,已成为组织管理能力、风险管理和非财务绩效的关键指标。虽然E S G并不是一个固定的概念,但是作为一个框架系统,已经成为评估企业行为和未来财务业绩的标准和策略[1]。从2 0 0 4年联合国发起的一项企业社会责任(corporate social responsibility)倡议算起,在将近20年的时间里,ESG运动已发展成一个全球现象,引发企业管理、金融投资、环境监测等领域对ESG进行讨论[2-4]。特别是,新兴技术突破带来的可持续发展问题逐渐凸显,引发系统性和多方面讨论[5-7]。根据欧洲银行管理局(EBA)关于ESG风险管理和监督的报告,环境因素包括温室气体排放、能耗和效率、空气污染物、用水和回收利用等,社会因素包括歧视、多样性和平等、机会、贫困和社区影响、供应链管理、培训和教育等,治理因素包括行为准则和商业原则、董事会多元化及架构等。这些因素是分析组织自身、技术发展、产业应用的重要基础。

当前,人工智能创新范式发生重大变革,正处于从专用智能向通用人工智能跃进的关键时期。在快速迭代中,大模型不仅对绿色环境、社会进步和治理创新带来了正面效益,同时也产生了负面影响,大模型研发训练消耗大量能源,对环境和能源体系形成挑战,潜在风险将影响社会稳定等。由于ESG理论兼具了全面性、系统性、科学性,本文将基于ESG视角及时准确、合理分析人工智能大模型发展效益和风险挑战。

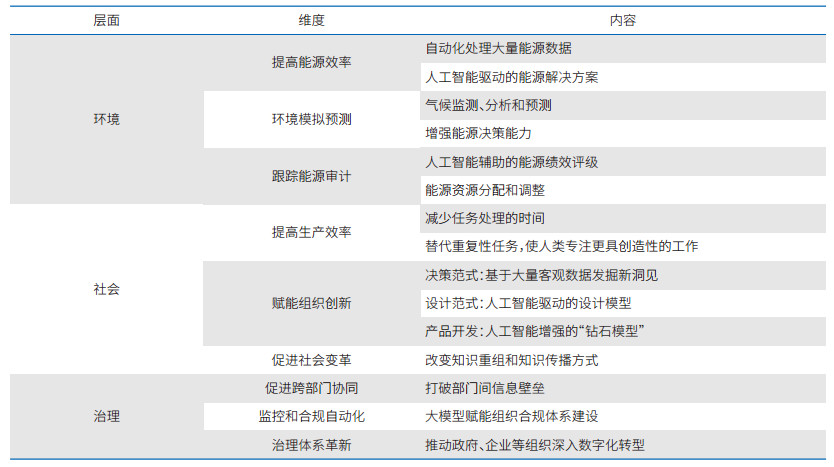

1.1 大模型环境效益大模型技术对于推动实现技术绿色创新、赋能环境变革,具有积极影响。总体看,大模型对环境的正面影响主要体现在提高能源效率、环境模拟预测、跟踪能源审计3个方面(表 1)。

(1)大模型成为代替其他机器的新技术手段,通过提高能源效率可促进可持续发展。人工智能具有自动化数据处理、加速知识获取和增强决策过程的能力[8],有可能在缓解全球变暖和减少温室气体排放方面发挥重要作用。通过发挥大模型的作用,形成人工智能驱动的能源解决方案,推动传统产业转型升级,实现高能耗产业的绿色发展[9]。人工智能可以通过自动化设计过程来帮助提高碳捕获和储存的效率。通过评估碳收集和储存的数据,人工智能可以提供更有效、更经济和可扩展的新的解决方案,有助于增强碳储存和温室气体吸收[10]。人工智能支持发展可再生能源和传统能源高度融合的能源系统[11],通过预测和优化能源系统配置,提高能源利用效率[12]。

(2)大模型拥有环境模拟预测,提升人类对环境问题的深入分析能力。环境不断生成大量的实时数据成为大模型分析的基础,AI for Science(人工智能驱动的科学研究)在气候领域得到快速应用,有助于人类实现气候监测、分析和预测[13],增强人类对于环境问题的分析能力。人工智能在促进气候分析和预测、能源管理、生物多样性保护,以及支持地球环境特征的数字孪生模拟上具有巨大潜力。了解人类活动与自然现象之间的相互作用是应对气候变化和生物多样性危机的关键,开发基于地球的数字孪生技术能够实现对地球的动态模拟,增强人类对环境变化的预测能力,并为环境政策制定提供科学依据[14]。

(3)大模型可以实现能源跟踪审计,形成对能源使用绩效的科学评估,服务构建更高效的资源管理、分配体系。机器学习算法的使用可以实现设计过程的自动化和评估能源输出与消耗数据,从而帮助提高可再生能源系统的有效性。不仅能提供更高效、更经济和可扩展的新设计,同时还可以通过采用来自气象卫星和其他来源的数据来提高能源预测的准确性[14]。科学合理地使用人工智能有助于避免能源浪费,并且减少资源错误分配等重大现实问题。此外,人工智能能够自动执行大部分分析和计算,从而减少完成能源审计所需的时间和精力[15]。通过自动化能源审计和优化可再生能源系统的设计来促进节能[14],可以帮助提高碳捕获和储存的效率。

1.2 大模型社会效益面向智能时代,大模型技术推动实现社会变革,对通过人工智能创新推动行业发展具有积极意义。大模型对社会的正面影响主要体现在提高生产效率、赋能组织创新、促进社会变革3个方面(表 1)。

(1)大模型成为重要的技术工具,在社会发展中形成机器赋能的生产模式,提高生产效率。生成式人工智能正在加速发展,通过数据驱动可以执行人类需要花费大量时间完成的任务,从而为企业节省时间和资源。机器可以自动化完成重复性任务,使人类能够专注于更具创造性和更高层次的工作,从而提高生产力[16]。大模型的快速发展实现了对部分劳动力的替代,改变了就业格局,并有可能通过以下方式彻底改变发展中国家的就业机会:人工智能克服语言障碍,赋能翻译和语言教育;人工智能提供技术技能,提高员工的数字素养和数字技能;人工智能通过承接重复的任务来提高雇主的效率;人工智能为技能发展提供具有成本效益的辅导服务;产生新的就业方式,例如提示工程师[14]。

(2)大模型赋能组织创新变革,改变产品和服务创新模式,形成基于大模型为特色的原生创新范式。在决策领域,大模型推动形成新的决策范式,通过对复杂数据集的洞察,使企业能够做出明智的决策,特别是在产品开发、营销策略和客户数据分析等领域。大模型凭借通顺流畅的语言生成,通用广泛的场景适应,通达全领域的知识覆盖和通畅自然的人机交互能力,正在推动决策范式从计算决策到智能决策的转变[17]。在设计领域,传统的以人为中心的设计范式遵循“设计→制作→使用”的实践逻辑,并通过新的洞察循环按照逻辑展开,在大模型驱动人工智能时代,设计遵循“解决方案→使用→数据→人工智能”的循环路径,通过及时获取大量数据,人工智能辅助甚至主导产品设计,更加直接满足客户需求[18]。在产品开发领域,以Transformer为代表的语言大模型有助于促进创新发散的过程,探索更大范围、更多元的解决方案空间,形成人工智能增强的“钻石模型”,在文本生成、情感分析、创意生成等领域具有丰富潜力[16]。

(3)大模型本质上改变了知识重组和知识传播的方式,使得用户获取专业知识的成本逐步降低。大模型通过对海量信息的训练,形成了知识重组的新方式,并且可以满足人们的个性化需要,使得人们获取专业知识的成本逐步降低[19]。在教育方面,大模型支持提供个性化学习,促进教育(优质教育);在医疗健康领域,大模型改善了诊断和医疗服务的可及性,为应对医生和护士的短缺,基于人工智能的系统越来越多地被开发和引入。例如,医院使用基于人工智能的图像读取系统诊断相关疾病,有助于节省劳动力和时间。在信息传播方面,大模型使内容生产方式和访问形式更加多元化,利用其强大的数据处理能力和生成技术,为用户提供更加丰富、便捷、个性化的信息体验,实现自动化内容生成、个性化内容定制、交互式信息检索等。

1.3 大模型治理效益大模型的应用将有可能赋能治理体系变革,推进社会健康发展,对治理的正面影响主要体现在促进跨部门协同、监控和合规自动化、治理体系革新3个方面(表 1)。

(1)大模型促进跨部门协同,打破部门间的信息壁垒,促进部门间的信息共享和协同工作。面向治理领域,大模型可以整合多领域、不同部门的数据,通过知识的大范围重组,使得各部门能够基于共同的数据源进行决策,提高决策的一致性和准确性,实现知识跨部门的共享;推动形成网络边界资源跨越和交互框架,边界跨越者(跨越组织间边界的个人)可以通过边界接口(如聊天机器人)实现资源交互[20]。在公共部门中,跨部门(环保、交通、规划等)的数据被集成到一个平台(模型)上,决策者可以基于完整的城市运行数据来制定更加科学合理的政策。

(2)大模型赋能组织合规体系建设,利用技术手段推进ESG变革。许多机构正在通过ESG框架评价企业的非财务活动。然而,使用现行ESG评级作为可靠指标存在局限性,直接提取各种媒体产生的非财务信息以提供客观的ESG信息非常重要,但关注ESG信息自动、直接提取和分类需求的研究有限[21]。使用机器学习的ESG仪表板将消除大数据中的噪音,并向用户提供最相关的ESG指标信息。不断从用户行为中学习并完善输出是实现可定制ESG报告的关键一步[22]。大模型有助于减少手动工作,通过构建合规体系,对ESG进行标准化评估。例如,研究探索利用BERT语言模型的多种策略,实现跨标签的新闻文档准确分类,可以实现在多种语言中的应用。

(3)大模型赋能治理体系革新,推动政府组织深入数字化转型,提升公共服务水平。人工智能对公共部门的政务服务提供、内部业务沟通、数据集成处理等具有极大的应用潜力。公共服务部门在引入人工智能解决方案时实现组织体系的变革,形成人工智能增强和人类协同的组织结构[23]。公共服务中的聊天机器人可以为社会弱势群体提供参与公共事务的机会,以弥合使用人工智能系统存在的数字鸿沟。未来的聊天机器人可能会更接近专家系统,集成决策能力[24],可以拥有并利用知识来引导用户解决问题,主动提出问题并引导对话流程,从而形成一种与公民协同的治理模式[25]。

2 ESG视角下人工智能大模型发展风险影响大模型发展除了带来上述效益外,同样带来新的风险挑战,文章将继续分析阐释大模型发展的影响。

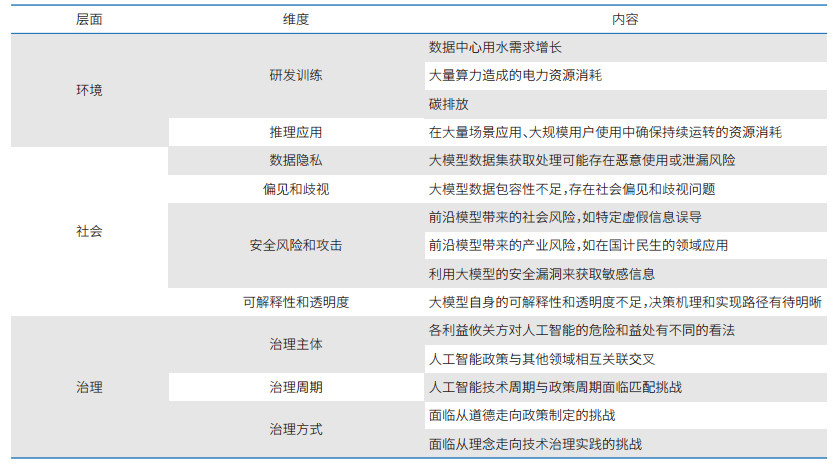

2.1 大模型的环境风险影响大模型发展呼唤绿色创新,以实现可持续发展。随着大模型技术的快速发展,其能耗问题逐渐凸显,对环境造成了很大的压力。大模型能耗问题的负面影响几乎贯穿了模型从开发到部署阶段的整个生命周期,给电力资源、水资源、碳排放带来了新的挑战。由于大模型的训练和推理需要消耗大量的计算资源和存储空间,能源消耗也相应地增加。同时,在研发训练过程中带来的巨大能源消耗和温室气体排放,对于“双碳”目标的落实提出挑战,对更高效率、更绿色的研发模式提出新要求。

(1)在研发训练阶段,大模型需要高度集中超大规模体量的算力资源以实现数据处理和模型训练等的迭代需要。在数据方面,收集、处理和存储规模庞大,对于数据基础设施的需求巨大。数据中心的使用对温室气体排放产生影响,据估计,美国温室气体排放量的0.5%来自数据中心[26]。此外,满足数据中心的高负荷运转需要大量用水冷却因运转而发热的设备,对水资源的使用产生更高要求。数据中心,包括支持生成式人工智能的数据中心,是美国耗水量最大的企业之一,这使得它们对有限水源的依赖加大,并影响流域的水资源[27]。因此,数据中心的位置和电力使用效率非常关键,通过合理选址、集中调度资源可以推进高效模型的研发训练。在算力方面,单个大模型开发和训练超过了常规模型的研发[28]。据估计,OpenAI在2023年1月的耗电量相当于175 000个丹麦家庭的年耗电量,GPT-3的训练排放了550吨二氧化碳①。此外,根据谷歌2022年的报告,由于气候变化和更频繁的热浪,预计开发人工智能对电力系统和数据中心的需求将增加,这可能导致云计算服务、数据存储等中断。维持大模型持续研发面临的高能源需求成为目前亟待解决的问题,需要结合可再生能源、区域情况统筹考虑能源利用效率。

① The environmental pollution behind the boom in artificial intelligence. (2024-04-23)[2024-10-03].https://www.calcalistech.com/ctechnews/article/ryjytypf2.

(2)在推理应用阶段,大模型基于场景驱动的创新解决方案,面临大量中小企业和公众的使用,需要充分的资源供给保障稳定运行。大模型在各行各业的广泛应用,将可能带来大量的能源消耗。研究表明,随着生成式人工智能快速发展,预计能源使用量将显著增加[29]。生成式人工智能和其他人工智能应用快速增长,对数据中心的需求不断增长,给本地能源网络带来了压力,并影响了新的住房开发②。早期研究主要关注与训练大型机器学习模型相关的能源和碳排放[30],Meta和谷歌研究表明训练阶段仅占机器学习相关整体能源消耗的20%—40%左右,推理(应用或使用人工智能模型)占60%—70%,模型开发(实验)占10%左右[31]。谷歌估计,2019—2021年机器学习占其总能源消耗的10%—15%[31]。由于模型规模和计算需求的急剧扩张,对于能源需求的增长趋势超越能源效率的改进速度,未来几年内人工智能相关的总能源使用量出现净增长。根据2023年数据,OpenAI每天仅运行ChatGPT就需要花费约70万美元③,维持其日常运营将消耗大量电力、算力等资源。2024年3月,ChatGPT每天需要处理超过2亿次请求,其电量消耗可能高达每天50万千瓦时,是普通家庭日耗电量的1.7万倍以上④。随着大模型快速迭代,支撑大模型发展的数据、算力等基础设施,将对资源供给提出更多要求。

② West London faces new homes ban as electricity grid hits capacity. (2022-07-28) [2024-10-08].https://www.ft.com/content/519f701f-6a05-4cf4-bc46-22cf10c7c2c0.

③ ChatGPT In Trouble: OpenAI may go bankrupt by 2024, AI bot costs company $700, 000 every day. (2024-07-26)[2024-10-08].https://www.firstpost.com/tech/news-analysis/openai-may-go-bankrupt-by-2024-chatgpt-costs-company-700000-dollars-every-day-12986012.html.

④ The obscene energy demands of AI. (2024-03-09) [2024-10-08].https://www.newyorker.com/news/daily-comment/the-obsceneenergy-demands-of-ai.

2.2 大模型的社会风险影响大模型技术不仅是一项技术进步,也涉及广泛的社会影响和伦理问题,需要负责任创新。这意味着在研发和应用大模型的过程中,需要充分考虑其社会影响和伦理问题,确保技术的合法性和道德性。因此,在研发和应用大模型时,需要充分考虑其社会价值和实际应用前景,确保技术的可持续发展和社会责任的履行。目前,大模型在发展过程中对个人和社会带来了诸多挑战:既包括由大模型自身不成熟所带来的问题,同时也涉及大模型在社会场景使用中的风险。主要可分为以下4个方面:数据隐私泄露、偏见和歧视、安全风险和攻击、可解释性不足和黑箱效应。

(1)大模型数据集获取处理可能存在恶意使用或泄漏风险。在不久的将来,大模型将成为数字经济发展的引擎。数据作为新质生产力中新的生产要素,数据自身的处理、应用、安全等影响效果发挥。大模型训练过程中本身涉及大量的数据,包括行业、组织、个体等多个层面。在大模型训练和赋能应用过程中,疏忽、失职、规范不严、恶意使用或故意泄漏等行为,都有可能带来数据安全风险,危害个人和社会利益。特别是在医疗、教育等特殊领域,涉及个人敏感信息,一旦监管不力,可能会侵犯个人基本权利和尊严。

(2)大模型数据包容性不足,将导致社会偏见和歧视问题。算法的质量很大程度上取决于数据的质量,如果数据源上存在不公平或者偏见,经过大模型的放大,可能导致更严重的歧视和不公平。特别是大模型具有同质性,如果上游基础大模型数据中存在偏见、不平等或歧视,下游的行业大模型可能面临同样风险,从而造成巨大的应用问题[32]。数据包容性对推动大模型健康发展,保障社会公平意义重大。例如,此前部分犯罪面部识别系统(亚马逊公司的Rekognition系统、PredPol预测性警务算法系统)因对少数族裔群体存在偏见而被禁止应用[12]。

(3)大模型面临安全风险和攻击挑战,可能影响社会发展稳定性。随着大模型快速迭代,前沿人工智能模型体现出更强的通用性、多模态,可以解决多种复杂任务,在发展过程中不断突破技术能力边界,进而解锁或引发一些不以特定规则出现的危险。例如,生成错误信息、深度伪造内容、误导特定群体,并进行社会或政治操纵,影响社会稳定。恶意用户可能利用语言大模型自动生成欺诈性或误导性内容,如假新闻、诈骗邮件或虚假评论。大模型作为通用技术,技术扩散范围广,渗透到各行各业,随着大模型基础设施作用愈加突出,经济和社会运行对技术和数据的依赖性就越强,未来面临的安全挑战(包括系统安全、数据安全、技术安全、不当使用、通过恶意攻击进行犯罪活动等)也就越严峻。同时,大模型可能成为网络攻击的目标,攻击者可能试图通过各种手段操纵模型的输出,或利用模型的安全漏洞来获取信息,包括敏感数据或知识产权。

(4)大模型自身的可解释性和透明度不足,决策机理和实现路径有待明晰。与传统的数学/统计模型不同,人工智能模型通常非常复杂,缺乏固有的可解释性。可解释性对于理解驱动人工智能系统运行的潜在机制至关重要,这些机制有助于产生可信的人工智能输出[33]。目前大模型决策过程通常是黑盒的,很难解释或理解模型为什么会产生特定的输出。特别是还存在着涌现现象,因此,在一些需要强解释、高透明的领域,如医疗、司法等,应用大模型面临较大的潜在风险。

2.3 大模型的治理风险影响大模型发展着重模型治理,实现安全性迭代。随着大模型的规模不断扩大和复杂度不断提升,其治理问题也变得越来越重要。大模型治理涉及模型的研发、部署、运行和维护的全过程,包括安全对齐、能力评测、风险评估等多个方面。目前,大模型对治理的挑战主要表现在治理主体、治理周期、治理方式3个方面(表 2)。

(1)大模型治理涉及各方利益主体,政策制定面临多方面协调。不同利益攸关方对人工智能的安全和发展存在不同看法,因此政策导向面临平衡难题。人工智能政策比许多其他政策更加复杂,这往往会导致机构间政策协调出现问题,以及不同政策目标(如数据隐私保护与使用个人数据定制化的商业服务)与特定政策客户群体(即行业、消费者或研究人员)既得利益之间的冲突[12]。因此政策协调需要统筹考虑大模型开发者、使用者、社会公众等不同主体诉求,以及人工智能技术发展水平,制定可行的、适配当前阶段的方案。在涉及各利益主体时,面临治理关系的变化,公私伙伴关系和合作在推动各行各业采用人工智能推动创新方面具有巨大潜力,这种伙伴关系可以推动人工智能驱动解决方案的开发,将技术创新的成果转化为社会发展成效。

(2)大模型治理面临技术生命周期和政策生命周期匹配问题。大模型技术生命周期涉及从开发到部署再到使用的全过程,政策生命周期包括从政策议程制定到实施再到评估阶段。由于大模型技术生命周期相对较短、迭代加速,技术的发展速度通常快于政策制定和调整的速度,将导致政策出台可能滞后于技术的发展。同时,大模型发展的不确定性和技术体系的高度复杂性进一步增加了政策制定的难度。此外,人工智能技术影响具有广泛性,为了防止其开发和使用主要由经济价值驱动,各国政府和国际社会需要建立建设性的伙伴关系,将各种人工智能利益攸关方聚集在一起[12],形成全球化的人工智能大模型治理方案。

(3)大模型治理面临技术手段和制度手段协调创新问题。人工智能技术仍在不断涌现和快速发展,由于技术具有高度不确定性,人工智能政策和监管框架范围难以确定。因此,传统的人工智能政策的重点较多从道德层面入手实现治理,如何通过凝练社会主义核心价值观和基础原则,并将其融入人工智能系统的设计、开发、部署和使用过程,成为技术治理的挑战。同时,相较于一般性技术,大模型作为通用目的技术并处于不断迭代中,在制度设计上面临短期和长期、局部和整体、安全和发展等多方面平衡协调问题[12, 34]。

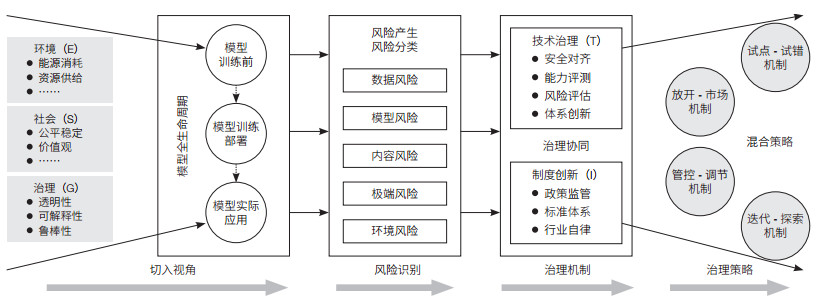

3 人工智能大模型风险治理模型文章基于ESG视角系统性梳理了大模型发展效益和风险影响,为推进大模型高质量可持续发展,研究进一步审视大模型发展过程中可能面临的潜在风险,并融合技术要素,构建了人工智能大模型风险治理模型(图 1)。该框架主要遵循“切入视角→风险识别→治理机制→治理策略”的逻辑展开。

|

| 图 1 人工智能大模型风险治理模型 Figure 1 Risk governance model for artificial intelligence foundation models |

从ESG视角较为综合地探究了人工智能大模型可能存在的多维影响,为系统认识大模型带来的风险奠定了基础。大模型技术研发应用呈现出技术生命周期特性,包括模型训练前、模型训练部署、模型实际应用3个典型阶段。在不同发展阶段,对环境、社会、治理都会带来一定挑战。

(1)环境方面主要关注大模型研发训练应用对于能源消耗及其带来的巨大碳排放、资源供给等挑战。这些挑战既存在于大模型研发训练环节,同时出现在推理应用环节中,贯穿整个大模型的发展周期。一方面,模型本身的数据处理、训练强度、运营维护等不仅对资源消耗较大,带来了潜在的大规模算力、电力等消耗,也带来了巨大碳排放,对实现人工智能可持续发展提出更高要求。另一方面,支持模型训练应用的能源体系布局、资源供给方式发生新变化,要在短时间内实现高强度的运行,对资源调度体系形成一定挑战。

(2)社会方面主要关注大模型对社会公平稳定、价值观(意识形态)等方面的挑战。这些挑战的产生在数据使用过程和模型训练中,并通过基础大模型的广泛应用泛化到不同垂直领域当中。一方面,作为通用技术,大模型具有广泛的社会用途,在医疗、教育、交通、城市治理、制造等领域中具有较大潜力,如果模型本身存在不足将通过应用传导至不同群体,产生连锁反应。此外,对数据使用的安全性提出更高要求,特别是在国计民生等关键领域。另一方面,因训练的语料和嵌入的价值理念不同,大模型在发展过程中对不同价值观产生判断,对于个体、群体意识形态产生影响。

(3)治理方面主要关注大模型的透明性、不可解释性、鲁棒性的挑战。这些挑战出现于数据处理、整个模型设计等过程中。一方面大模型的透明性问题、不可解释性问题涉及数据本身的获取、处理和应用,使得人工智能系统使用面临较大挑战,特别是对人工智能产生结果具有高要求的领域。作为一个高度复杂的人工智能系统,驱动结果产生的机制至关重要。另一方面,大模型发展过程还面临鲁棒性问题,即如何在不同场景中确保模型结果稳定、输出可靠,同时避免或降低受到外部各类攻击、数据投毒的影响。

3.2 大模型发展风险识别研究基于ESG视角,从大模型训练、部署、应用的不同阶段,依次识别出典型风险,涉及数据风险、模型风险、内容风险、极端风险、环境风险5类。

(1)数据风险是指大模型训练应用中数据部分涉及的风险问题,包括数据隐私和产权、泄漏、篡改、滥用、投毒等。缺乏规范使用和处理数据,可能会导致数据隐私和产权问题。大模型在训练和使用过程中需要大量的数据,如果数据管理不严格,就可能导致数据泄露,从而对用户隐私和企业安全造成威胁;大模型所处理的数据可能会被恶意修改,导致模型输出错误或者产生不良影响;如果数据使用不当,例如超范围、超用途使用,就可能引发数据滥用问题;此外,有意或恶意地向数据集中引入虚假、恶意或有害的数据,利用训练或者微调过程使得模型中毒,将操纵、损害机器学习模型的性能。

(2)模型风险是指大模型系统结构中涉及的风险问题,包括模型自身漏洞不足被篡改使用、攻击的风险。攻击者可能会利用模型中的漏洞,实施注入攻击、对抗样本攻击等,导致模型失效、误分类或被控制。此外,攻击者还可能会利用模型进行网络攻击、数据泄露等恶意行为,给企业和用户带来巨大的损失。在模型的训练和部署过程中,可能会存在一些未知的漏洞和错误,导致模型出现偏差、过拟合等问题。这些问题可能会导致模型的性能下降、预测结果不准确等,甚至可能会对用户的隐私和安全造成威胁。

(3)内容风险是指大模型在内容生成中涉及的风险问题,包括偏见歧视问题、模型幻觉、意识形态和政治风险等。由于大模型的训练数据大多来源于现实世界,如果数据中的偏见未经处理或修正,就可能被大模型放大,导致输出结果存在偏见或歧视。大模型使用中存在幻觉风险,输出结果可能包含错误或虚假的信息,涉及专业内容,人们很难准确判断其输出内容的可靠性。此外,会面临意识形态和政治风险,例如某些国家或组织可能利用大模型来操纵舆论或宣传特定政治立场。

(4)极端风险是指大模型被使用在极端场景中,造成严重后果,产生失控风险,对社会和环境造成危害等。随着前沿模型的能力逐渐增强,在开放域中设计安全边界模型变得越来越困难。大模型既可能加速科学和技术进展,但是也存在被不法群体用于生物化学武器、核武器、基因编辑等特殊场景的风险,从而对社会、经济和环境产生多方面严重影响。随着更强大的前沿模型被研发出来,突破人的能力,在使用和发展中缺失规范规则探索,可能存在新的不可控问题。

(5)环境风险是指大模型在使用中对环境友好造成的挑战。大模型研发整体成本巨大,大规模算力、高质量数据集、尖端人才智力成本三要素构成大模型训练总成本。尽管大模型对可持续发展具有正向外部性,例如在智能能源、绿色交通等方面的应用,但大模型自身在训练和运行过程中产生的巨大能耗,会导致碳排放的增加,从而带来负向影响。根据国际能源署数据,数据中心的温室气体排放量已经占到全球温室气体排放量的1% 左右。随着人工智能大模型和对云计算需求的增长,这一数字预计还会继续上升。大模型研发训练带来巨量碳排放,需要在绿色可持续发展中寻找平衡点。

3.3 大模型发展风险治理机制根据风险类型,进一步探究适合大模型发展的治理机制,从技术治理和制度创新两个视角双管齐下。

(1)大模型技术治理包括安全对齐、能力评测、风险评估、体系创新等方面,通过技术手段来确保技术研发的安全性和技术本身的可控性。大模型技术治理是一个复杂而重要的过程,包括安全对齐、能力评测、风险评估和大模型体系创新4个关键方面。这些方面相互关联,共同确保技术研发的安全性和技术本身的可控性。①安全对齐是指将大模型技术的安全需求与研发过程对齐,确保在技术设计和开发阶段就充分考虑安全性问题。这涉及识别潜在的安全风险,制定相应的安全策略和标准,并在整个研发过程中实施这些策略和标准。②安全能力评测是对大模型安全性的全面评估,涉及伦理问题、社会问题等多个方面。通过对这些能力的评测,可以了解技术的优势和不足,为后续的技术优化和改进提供依据。③风险评估是对大模型技术可能带来的风险的评估和管理。这些风险可能来自技术的复杂性和不确定性,也可能来自外部环境的影响。通过风险评估,可以识别潜在的风险,并采取相应的措施来降低风险。④大模型体系创新是指通过研发新技术和方法,不断完善和优化大模型技术的体系结构。这涉及对现有技术的深入理解和改进,以及对新技术的研究和应用。通过体系创新,可以提升大模型技术的安全性、鲁棒性,满足不断变化的需求。

(2)大模型制度创新包括政策监管、标准体系、行业自律等方面,通过制度设计满足新兴技术创新过程中不确定性和风险性,实现安全发展。①探索包容审慎的政策监管制度。一方面,需要确保技术的合法性和道德性,防止其被滥用或产生负面影响。另一方面,也需要灵活应对技术发展的快速变化,及时调整和完善相关规定,以适应前沿模型的进步。②建立一套全面的大模型技术标准体系对于行业的健康发展至关重要。这些标准涉及数据处理、模型训练、性能评估等多个环节,旨在确保技术的可靠性和互操作性。通过标准化,可以降低行业的进入门槛,促进技术交流和合作,同时也为监管机构提供评估和监督的依据。③行业自律强调企业和应用开发者应遵守行业伦理,自觉承担社会责任,确保技术开发和应用不会造成不良后果。通过第三方机构,实现规范共识、客观评测、联合探索前沿解决方案等方式,共同推动行业的可持续发展。

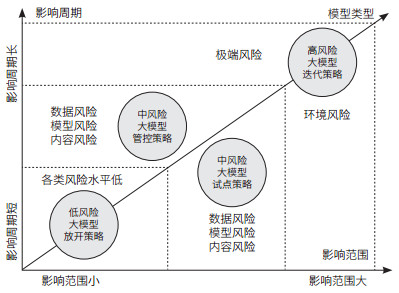

3.4 大模型风险治理策略目前各界对人工智能系统风险治理形成了广泛讨论。欧盟《人工智能法案》将人工智能系统分为不可接受风险、高风险、有限风险以及最低风险4类,并针对性采取相应监管措施。OpenAI、Anthropic、DeepMind等机构针对人工智能系统设定不同安全风险等级,高度重视前沿大模型风险治理,实施额外的安全治理举措。结合大模型安全治理实践,研究发现不同人工智能系统带来的风险及其对应的治理存在差异,本文在参考欧盟《人工智能法案》基础上,将大模型分为低风险、中风险和高风险3类,并且结合大模型所面临风险类型和程度的不同,提出针对性治理策略(图 2)。需要指出的是,这4类治理策略并非相互独立,可以针对不同风险探索混合治理策略,形成更加包容审慎的大模型创新治理模式,模型的风险程度将伴随治理发生动态变化,实现大模型高质量发展。

|

| 图 2 人工智能大模型风险治理策略 Figure 2 Risk governance strategies for artificial intelligence foundation model 不同模型所面临风险有重合,图中仅列举出各类模型典型风险 The risks faced by different models overlap.Figure 2 only lists the typical risks of each model |

(1)放开策略,针对影响范围小、影响周期短的模型风险。这类风险通常表现为局部问题或短期内的技术缺陷。对于这类风险,主要体现在性能提升上,放开策略是可行的选择。例如,微软研究院等机构利用多模态大模型进行癌症分型诊断,应用于癌症诊断和预后等精准健康领域,虽然在多任务上取得了领先效果,但在某些特定任务层面依然具有较大的进步空间[35]。具体来说,可以允许模型在一定范围内进行试运行,通过市场的自然选择来淘汰那些存在风险(性能较低)的模型。这种策略利用了市场调节机制,允许模型在真实环境中自我优化和调整。

(2)管控策略,针对影响范围小、影响周期长的模型风险。这类风险可能涉及长期的技术发展趋势或潜在的技术瓶颈。对于这类风险,管控策略更为合适。这意味着在模型的研发和应用过程中,需要建立长期的监测和评估机制,对可能出现的风险进行及时预警和管理。DeepMind与剑桥大学、牛津大学等联合提出通用模型评测框架(模型内部评估、外部专家和审计员评估、模型部署评估),在大模型研发中构建“早期预警系统”,将模型评测嵌入到整个模型训练和部署的重要决策过程中,实现负责任的模型创新[36]。这种策略利用了周期性调节机制,有助于在长期范围内控制风险。

(3)试点策略,针对影响范围大、影响周期短的模型风险。这类风险通常涉及广泛的外部因素和快速变化的环境。对于这类风险,允许在有限的范围内先行先试,通过实际运行来评估模型的性能和安全性。再根据试点应用的结果反馈机制,不断调整优化模型风险治理。在自动驾驶领域,Wayve开发了快速、连续和无缝的学习循环系统(fleet learning loop),在各种车辆中收集真实世界的驾驶数据,然后上传到云端处理,再将迭代后的模型部署到车端,升级车辆的自动驾驶功能,不断提升模型可解释性。这种策略充分利用了试错机制,有助于快速识别和解决潜在的问题。

(4)迭代策略,针对影响范围大、影响周期长的模型风险。这类风险可能涉及深层次的技术难题或长期的社会影响。对于这类风险,迭代策略更为合适。美国新兴机构Anthropic提出负责任扩展策略(responsible scaling policy)应对人工智能灾难性风险,定义了人工智能安全级别(ASL)框架,不会立即定义所有未来的ASL及其安全措施,而采取迭代承诺⑤。迭代策略强调在研发过程中不断进行模型的优化和改进,通过逐步迭代的方式来降低风险。这种策略利用了技术探索机制,鼓励持续创新和改进,从而更好地应对长期的风险挑战,避免“一刀切”扼杀大模型的创新活力。

⑤ Anthropic’s responsible scaling policy.(2023-09-19)[2024-10-08].https://www.anthropic.com/news/anthropics-responsible-scaling-policy.

4 结语人工智能大模型治理已成为国际社会共同关注的议题。各国政府正致力于制定政策与制度,以应对大模型带来的风险和挑战。欧盟提出了一系列旨在确保人工智能安全、透明和可信赖的指导原则和法规。从《通用数据保护条例》(General Data Protection Regulation)到《人工智能法案》(Artificial Intelligence Act),欧盟致力于构建一个全面的人工智能监管体系,防范潜在风险。美国从《人工智能权利法案蓝图》(Blueprint for an AI Bill of Right)到《人工智能风险管理框架》(Artificial Intelligence Risk Management Framework),再到拜登政府颁布第14110号行政命令,美国持续关注人工智能技术的负责任使用和创新竞争力。中国高度重视人工智能发展和治理,《中华人民共和国数据安全法》《中华人民共和国个人信息保护法》等为人工智能技术的规范应用提供了法律基础,2023年出台的《生成式人工智能服务管理暂行办法》,在确保安全和伦理的前提下,鼓励大模型创新和应用。面向未来,我国要实现大模型可持续和高质量发展,在创新应用同时必须考虑环境、社会、治理等多方面风险,探索多元治理模型更好适应大模型创新发展规律。

| [1] |

Eccles R G, Lee L E, Stroehle J C. The social origins of ESG: An analysis of innovest and KLD. Organization & Environment, 2020, 33(4): 575-596. |

| [2] |

Rau P R, Yu T. A survey on ESG: Investors, institutions and firms. China Finance Review International, 2023, 14(1): 3-33. |

| [3] |

Tsang A, Frost T, Cao H J. Environmental, social, and governance (ESG) disclosure: A literature review. The British Accounting Review, 2023, 55(1): 101149. DOI:10.1016/j.bar.2022.101149 |

| [4] |

De Giuli M E, Grechi D, Tanda A. What do we know about ESG and risk? A systematic and bibliometric review. Corporate Social Responsibility and Environmental Management, 2024, 31(2): 1096-1108. DOI:10.1002/csr.2624 |

| [5] |

张兆翔, 张吉豫, 谭铁牛. 人工智能伦理问题的现状分析与对策. 中国科学院院刊, 2021, 36(11): 1270-1277. Zhang Z X, Zhang J Y, Tan T N. Analysis and strategy of AI ethical problems. Bulletin of Chinese Academy of Sciences, 2021, 36(11): 1270-1277. DOI:10.16418/j.issn.1000-3045.20210604002 (in Chinese) |

| [6] |

Buhmann A, Fieseler C. Towards a deliberative framework for responsible innovation in artificial intelligence. Technology in Society, 2021, 64: 101475. DOI:10.1016/j.techsoc.2020.101475 |

| [7] |

Vallès-Peris N, Domènech M. Caring in the in-between: A proposal to introduce responsible AI and robotics to healthcare. AI & SOCIETY, 2023, 38(4): 1685-1695. |

| [8] |

Keding C, Meissner P. Managerial overreliance on AIaugmented decision-making processes: How the use of AIbased advisory systems shapes choice behavior in R & D investment decisions. Technological Forecasting and Social Change, 2021, 171: 120970. DOI:10.1016/j.techfore.2021.120970 |

| [9] |

Tian H N, Zhao L Y, Li Y F, et al. Can enterprise green technology innovation performance achieve "corner overtaking" by using artificial intelligence? —Evidence from Chinese manufacturing enterprises. Technological Forecasting and Social Change, 2023, 194: 122732. DOI:10.1016/j.techfore.2023.122732 |

| [10] |

Priya A K, Devarajan B, Alagumalai A, et al. Artificial intelligence enabled carbon capture: A review. Science of the Total Environment, 2023, 886: 163913. DOI:10.1016/j.scitotenv.2023.163913 |

| [11] |

Vinuesa R, Azizpour H, Leite I, et al. The role of artificial intelligence in achieving the sustainable development goals. Nature Communications, 2020, 11(1): 1-10. DOI:10.1038/s41467-019-13993-7 |

| [12] |

Moon M J. Searching for inclusive artificial intelligence for social good: Participatory governance and policy recommendations for making AI more inclusive and benign for society. Public Administration Review, 2023, 83(6): 1496-1505. DOI:10.1111/puar.13648 |

| [13] |

Bi K F, Xie L X, Zhang H H, et al. Accurate medium-range global weather forecasting with 3D neural networks. Nature, 2023, 619: 533-538. DOI:10.1038/s41586-023-06185-3 |

| [14] |

Mannuru N R, Shahriar S, Teel Z A, et al. Artificial intelligence in developing countries: The impact of generative artificial intelligence (AI) technologies for development. Information Development, 2023. DOI:10.1177/02666669231200628 |

| [15] |

Khan O, Parvez M, Alansari M, et al. Application of artificial intelligence in green building concept for energy auditing using drone technology Cunder different environmental conditions. Scientific Reports, 2023, 13: 8200. DOI:10.1038/s41598-023-35245-x |

| [16] |

Bouschery S G, Blazevic V, Piller F T. Augmenting human innovation teams with artificial intelligence: Exploring transformer-based language models. Journal of Product Innovation Management, 2023, 40(2): 139-153. DOI:10.1111/jpim.12656 |

| [17] |

何赛克, 张培杰, 张玮光, 等. 大模型时代下的决策范式转变. 中国地质大学学报(社会科学版), 2023, 23(4): 82-91. He S K, Zhang P J, Zhang W G, et al. Paradigm shift in decision-making in the era of large language models. Journal of China University of Geosciences (Social Sciences Edition), 2023, 23(4): 82-91. (in Chinese) |

| [18] |

Verganti R, Vendraminelli L, Iansiti M. Innovation and design in the age of artificial intelligence. Journal of Product Innovation Management, 2020, 37(3): 212-227. DOI:10.1111/jpim.12523 |

| [19] |

Kanbach D K, Heiduk L, Blueher G, et al. The GenAI is out of the bottle: Generative artificial intelligence from a business model innovation perspective. Review of Managerial Science, 2024, 18(4): 1189-1220. DOI:10.1007/s11846-023-00696-z |

| [20] |

Wei R Q, Vize R, Geiger S. Boundary resource interactions in solution networks. European Journal of Marketing, 2022, 56(2): 532-561. DOI:10.1108/EJM-07-2020-0522 |

| [21] |

Lee J, Kim M. ESG information extraction with crosssectoral and multi-source adaptation based on domain-tuned language models. Expert Systems with Applications, 2023, 221: 119726. DOI:10.1016/j.eswa.2023.119726 |

| [22] |

Asif M, Searcy C, Castka P. ESG and Industry 5.0: The role of technologies in enhancing ESG disclosure. Technological Forecasting and Social Change, 2023, 195: 122806. DOI:10.1016/j.techfore.2023.122806 |

| [23] |

Maragno G, Tangi L, Gastaldi L, et al. AI as an organizational agent to nurture: Effectively introducing chatbots in public entities. Public Management Review, 2023, 25(11): 2135-2165. DOI:10.1080/14719037.2022.2063935 |

| [24] |

Watson H J. Preparing for the cognitive generation of decision support. MIS Quarterly Executive, 2017, 16(3): 153-169. |

| [25] |

Cortés-Cediel M E, Segura-Tinoco A, Cantador I, et al. Trends and challenges of e-government chatbots: Advances in exploring open government data and citizen participation content. Government Information Quarterly, 2023, 40(4): 101877. DOI:10.1016/j.giq.2023.101877 |

| [26] |

Siddik M A B, Shehabi A, Marston L. The environmental footprint of data centers in the United States. Environmental Research Letters, 2021, 16(6): 064017. DOI:10.1088/1748-9326/abfba1 |

| [27] |

Mytton D. Data centre water consumption. NPJ Clean Water, 2021, 4: 11. DOI:10.1038/s41545-021-00101-w |

| [28] |

Chang C H, Kidman G. The rise of generative artificial intelligence (AI) language models-challenges and opportunities for geographical and environmental education. International Research in Geographical and Environmental Education, 2023, 32(2): 85-89. DOI:10.1080/10382046.2023.2194036 |

| [29] |

Chien A A, Lin L, Nguyen H, et al. Reducing the Carbon Impact of Generative AI Inference (today and in 2035)// Proceedings of the 2nd Workshop on Sustainable Computer Systems. Boston: ACM, 2023: 1-7.

|

| [30] |

Strubell E, Ganesh A, McCallum A. Energy and policy considerations for deep learning in NLP// Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Italy: Association for Computational Linguistics, 2019: 3645-3650.

|

| [31] |

Patterson D, Gonzalez J, Hölzle U, et al. The carbon footprint of machine learning training will plateau, then shrink. Computer, 2022, 55(7): 18-28. DOI:10.3969/j.issn.1006-4052.2022.07.006.007 |

| [32] |

滕妍, 王国豫, 王迎春. 通用模型的伦理与治理: 挑战及对策. 中国科学院院刊, 2022, 37(9): 1290-1299. Teng Y, Wang G Y, Wang Y C. Ethics and governance of general models: Challenges and countermeasures. Bulletin of Chinese Academy of Sciences, 2022, 37(9): 1290-1299. DOI:10.16418/j.issn.1000-3045.20220505003 (in Chinese) |

| [33] |

孔祥维, 王子明, 王明征, 等. 人工智能使能系统的可信决策: 进展与挑战. 管理工程学报, 2022, 36(6): 1-14. Kong X W, Wang Z M, Wang M Z, et al. Trustworthy decision-making in artificial intelligence-enabled systems: Progress and challenges. Journal of Industrial Engineering and Engineering Management, 2022, 36(6): 1-14. (in Chinese) |

| [34] |

郁建兴, 刘宇轩, 吴超. 人工智能大模型的变革与治理. 中国行政管理, 2023, (4): 6-13. Yu J X, Liu Y X, Wu C. The social transformation and governance of large generative artificial intelligence models. Chinese Public Administration, 2023, (4): 6-13. (in Chinese) |

| [35] |

Xu H W, Usuyama N, Bagga J, et al. A whole-slide foundation model for digital pathology from real-world data. Nature, 2024, 630: 181-188. |

| [36] |

Shevlane T, Farquhar S, Garfinkel B, et al. Model evaluation for extreme risks. ArXiv, 2023. DOI:10.48550/arXiv.2305.15324 |