2. 中国发展战略学研究会 北京 100190;

3. 北京市社会科学院 北京 100101

2. Chinese Association of Development Strategy Studies, Beijing 100190, China;

3. Beijing Academy of Social Sciences, Beijing 100101, China

人工智能技术的飞速演进和广泛应用,正引领人类社会经历一场空前变革。这些变革不仅仅局限于技术层面,更深远地影响到了伦理观念、社会治理模式及人与技术的共生关系。在这样的发展趋势下,传统封闭的[1]、单向的伦理规范制定模式已显不足,难以有效应对日益复杂的伦理挑战。鉴于人工智能的广泛影响和涉及的人群众多,探讨一种多元主体参与、交互式、开放性的参与式伦理规约变得至关重要,对促进技术进步与伦理规范的协同发展,以及构建更好的智能社会治理体系都有着重要意义。

1 人工智能时代对传统伦理范式提出新挑战在当今时代,人工智能技术的迅猛发展正日益成为现代社会的关键特征,其影响涵盖了从经济到医疗、教育乃至司法等各个领域。人工智能所具有的高度自主性和强大的学习能力,提升了操作效率及便捷性,却也带来了数据隐私侵犯、算法偏见和责任界定等一系列伦理挑战。这些挑战不仅威胁个人的权利,也对社会的公正性和传统道德准则提出了严峻的考验。

1.1 人工智能伦理规约是国际关注的重要议题从19世纪文学作品中第一次提及人性与科学的矛盾[2],到20世纪提出“机器人三定律”[3],再到2023年多国推出人工智能相关的法案,对于人工智能的伦理探索涉及原则制定、指南及政策发布、评估和监督机制建立等多个方面。然而,传统的伦理规范方法难以应对人工智能技术的快速发展。以生成式人工智能为例,其带来的数据安全风险已超出现有保护框架的范畴[4]。这种技术与伦理失衡的状况,使改变人工智能伦理规范制定方式变得愈发迫切。

欧美国家在人工智能伦理规约研究方面已取得了一定进展,但这些努力主要集中在原则制定层面,难以完全应对人工智能技术快速发展带来的具体挑战。2021年11月,联合国教科文组织(UNESCO)通过了首个全球性关于人工智能伦理的协议——《人工智能伦理问题建议书》,确定了人工智能健康发展所需的共同价值观和原则。2023年,欧盟和美国分别推出《人工智能法案》和《人工智能权利法案蓝图》,强调确保人工智能系统的安全有效性、防止算法歧视、保护数据隐私、提供通知和解释,以及提供人类替代、考虑和后备选择等基本原则,旨在保护公民在人工智能时代的基本权利。然而,“数字治理需要在法治框架下进行,但现有法律体系难以完全适应人工智能等新兴技术带来的挑战”[5],探索新型治理方式成为必然。

1.2 中国高度重视人工智能伦理的理论探索和政策实践我国人工智能伦理研究起步较晚,到21世纪才开始受到关注,近年来逐渐成为重要研究方向之一。当前研究整体呈现出从原则到具体、从本体到应用、从个例到整体[6]的趋势。在关注内容上,也呈现出从单一伦理问题的讨论转向整体的伦理规约体系及对社会治理(如经济安全、社会稳定、教育公平、医学伦理等多方面)[7]影响的探索。

在学界关注理论探索的同时,政策层面也在不断完善。2017年我国正式发布《新一代人工智能发展规划》,人工智能伦理规约开始逐步与国际规范接轨。2021年9月,国家新一代人工智能治理专业委员会发布了《新一代人工智能伦理规范》,旨在将伦理道德融入人工智能全生命周期;同年出台的《中华人民共和国个人信息保护法》,也通过法律行为引导具体伦理实践,对人工智能依赖的数据给予更完善的保护。2023年发布的《生成式人工智能服务管理暂行办法》在对行业做出了具体规范的同时,最大程度地给技术更为宽阔发展空间。

尽管目前在人工智能伦理规约方面已经取得了一些成果,但面对人工智能技术的飞速发展,传统伦理规约方式逐渐表现出滞后和不适应,自上而下的治理模式并不适用于当前技术场景。与之相比,参与式伦理规约强调多元主体参与、伦理原则的动态性和适应性,提供了一个更为开放、灵活和公正的伦理决策框架,成为解决人工智能伦理挑战的重要治理规范。

参与式伦理规约是一个综合性的决策框架和治理模式,其核心在于多元利益相关者的广泛参与,以协作和共识为基础来制定和执行伦理规范。在参与式伦理规约中,伦理决策过程不是由少数决策者单方面主导,而是通过多元视角的融合,形成更加全面和平衡的伦理解决方案。参与式伦理规约在弥补了传统伦理规约容易忽视的大众及多元主体参与的空白,为如何更好地履行伦理和社会责任提供方向。

人工智能技术的快速发展在个体伦理、社会伦理、风险伦理和程序伦理等多个维度对传统伦理范式提出全方位挑战。比如,在个体伦理层面,人工智能模糊了道德行为主体界限,使得个人权责难以明晰界定;同时可能侵犯个人隐私、尊严等权利。在社会伦理层面,人工智能可能加剧数字鸿沟和财富分配不平等,影响社会公平正义;从风险维度,人工智能决策的不透明性使其风险难以预见把控,而其自主性和效率又可能带来极大负面后果;从程序伦理方面,人工智能系统的开发缺乏伦理考量,难以保障其在运行中始终遵守伦理规范。

尤为重要的是,人工智能的不断发展挑战了传统伦理基本预设。传统伦理主要基于人的理性、自由意志和情感等特质,人工智能系统是否具备这些特质仍存在很大的争议:人工智能是否能够作为责任承担的行为主体?这种责任该如何界定?人类是否应当将自己的价值观和伦理原则强加于人工智能?这些问题触及了新技术时代伦理建构之根本。

面对诸多挑战,参与式伦理规约①为重塑人工智能伦理范式提供了新思路。它强调要吸收多元利益相关方参与伦理规范制定,动态调整以适应新问题。通过持续对话、差异协调,在发展人工智能的同时规范其发展路径。这一过程强调人工智能的伦理属性建构,而非简单地将其视为工具;同时也强调人类通过参与式方式来主导伦理规范,以价值观自觉引领人工智能的发展方向。

① 参与式伦理规约作为一种新兴的治理方法,目前仍处于发展阶段。它吸收了参与式行动研究和社区基础研究的理念,并将其应用于人工智能伦理治理的新领域。虽然这一概念在理论上已经形成框架,但在实践中还需要进一步探索和完善。各国和地区在应用这一方法时也呈现出不同的特点和侧重点。因此,参与式伦理规约可以被视为一个正在演进的概念,其具体实施方式和效果还需要在未来的实践中不断验证和调整。2023年发布的《生成式人工智能服务管理暂行办法》中已有所体现,随着人工智能技术的快速发展和应用场景的不断拓展,参与式伦理规约的内涵和外延也将随之丰富和完善。

2 参与式伦理:打造公众参与的人工智能治理新范式人工智能技术使传统社会治理结构面临前所未有挑战。这一挑战不仅源于技术本身的复杂性和不断演进的性质,也源于其对社会规范和行为模式的深远影响。作为一种新兴治理框架,参与式伦理规约不仅可以有效应对新挑战,也为社会治理提供了全新视角和框架。

参与式伦理规约起源于20世纪中期的参与式行动研究和社区基础研究。其核心理念在于多方合作和共同决策[8],赋予所有社会主体参与伦理规范制定的权利,促进透明度和共同参与,将伦理决策过程与各主体的真实需求和期望[9]更紧密地联系起来。

在人工智能时代,参与式伦理规约为社会治理提供了新的范式。它强调在人工智能技术的研发、应用和监管过程中,广泛吸收多元利益相关方的参与,通过持续对话和协商来制定伦理规范。这种参与式的方法不仅有助于平衡不同群体的利益诉求,也能更好地应对人工智能带来的复杂伦理挑战。例如,在制定《生成式人工智能服务管理暂行办法》的过程中,就采取了广泛征求意见的做法,体现了参与式伦理规约的理念。

(1)参与式伦理规约是适应技术与社会演进的开放性治理框架。为应对技术快速发展和社会文化多元化的挑战,将伦理原则的制定转化为多元主体共同参与过程,是十分必要的。参与式伦理规约不仅促进了伦理标准的持续演进,还增强了对不断变化环境的适应能力;确保治理策略既具时效性又保持灵活性,从而使伦理规范更加适应时代步伐,有效应对社会和技术领域的新变化。在这种模式下,伦理决策不再仅由专家、政府制定,而是成为一个多元主体参与的持续对话过程。这种方式特别适用于应对人工智能挑战,因为它使伦理标准能够与技术进步同步更新,提升了治理的公正性和实用性。这种社会治理理念推动了从传统的自上而下的治理模式向更民主化、多元化和参与性强的治理结构转变,体现了人工智能时代社会治理结构的根本变革。

(2)参与式伦理规约通过促进技术与社会文化的互动重构社会治理模式。人工智能时代社会治理展现出技术进步与社会文化交融的复杂性,技术不仅是推动社会结构和治理模式变革的动力,也是社会文化影响和人类活动反映的产物。在技术改变决策方式、社交模式甚至价值观的同时,社会的需求和期望也在塑造技术的发展方向和应用场景。这种交织意味着不能单纯地从技术或社会角度来看待社会治理变革,而是应寻求二者之间相互作用,以理解社会治理的全面变革。参与式伦理规约突出了技术发展与社会需求之间的双向互动,强调治理结构必须适应快速变化的技术和社会文化。这种方法将不同社会群体、政策制定者、技术专家和用户都纳入伦理决策过程,为社会治理带来新维度;它不仅加深了对技术影响的理解,还促进了治理结构的灵活性和包容性,确保社会治理能够有效应对人工智能时代的挑战。

(3)参与式伦理规约是大众参与的社会治理新范式。“人工智能技术的发展正在重塑社会现实,带来社会治理领域的新变革”[10]。社会治理核心目标是满足社会大众的需求和利益,而社会大众所表达的需求和意见,也构成了政府和各社会组织制定和实施治理政策的基础和出发点。在数字化时代,大众参与呈现出新的内涵和形式,经历了前所未有变革。这场变革不只体现在参与方式的多样化上,也在更深的层面上,触及公民参与模式的根本性重塑。

在传统治理模式中,大众的参与主要是通过对既有政策或预期政策的反馈来实现的。而在网络、社交媒体和其他数字平台的普及下,大众对于治理的参与变得更加直接、广泛[11]。在一些情况下,通过这些渠道的发声,大众甚至可以直接推动政策的制定。这种直接的、自下而上的参与方式,改变了大众在治理政策制定中的角色定位,使其从被动的反馈者转变为决策过程中的主动参与者[12]。这种转变意味着,需要在理论层面重新审视和定义大众的角色、权力与责任。此外,数字化技术还为大众参与带来了新的机遇挑战。一方面,技术使得信息传播更为迅速、广泛,大众的声音可以更容易被听到;另一方面,技术也可能导致信息的碎片化、回音室效应和算法偏见,这些都会影响大众参与的质量和效能。

3 参与式伦理:构建“以人为本”的人工智能治理新框架借助人工智能的先进技术,如机器学习和深度学习,传统决策中的人工分析局限得到了有效克服,延伸了社会治理的触角、拓展了社会治理的空间[13]。参与式伦理规约旨在确保技术创新与伦理规范同步前进。该框架的核心在于其前瞻性和适应性,不仅解决现存的伦理问题,而且通过持续的监测和评估,预见并应对未来可能出现的伦理挑战。在促进伦理规范与技术创新的协同进步方面,参与式伦理规约提倡开放的社会对话,以确保各种声音和视角能够被听见并纳入决策过程。这种包容性的对话环境有助于揭示和理解新技术可能带来的伦理复杂性,从而在技术应用初期就考虑伦理影响。参与式伦理规约通过社会对话、教育推广和政策创新,确保了伦理规范能够与技术创新齐头并进,形成一种动态的、互相促进的关系。这种协同进步不仅使技术发展更加贴近人类的核心价值和社会的整体利益,而且为构建一个更加公正、可持续的未来奠定了坚实的基础。

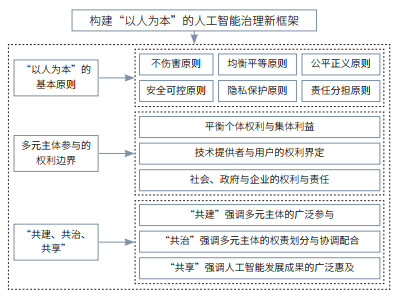

参与式伦理规约为人工智能治理提供了一个独特视角,强调了多元主体的协同参与及权利边界的明确。参与式伦理规约的治理框架,通过确保技术的透明性、大众的参与度和伦理决策的动态性,努力推进构建一个既尊重技术进步又重视人类核心价值的智能社会,为人工智能的持续、公正和透明发展奠定了坚实基础(图 1)。

|

| 图 1 构建“以人为本”的人工智能治理新框架 Figure 1 Building a "human-centered" new framework for artificial intelligence governance |

尽管“后人类”语境[14]下存在对“人”的重要性质疑,人的自我意识、道德判断和自由意志在伦理规范制定中仍发挥不可替代的作用②。参与式伦理规约强调人在制定伦理规范和批判性思考中的主导地位,确保技术发展以人的价值为导向。同时也突出人的独特性,尤其是在认知能力、情感反应和文化背景方面。这些特质在伦理决策中发挥关键作用[15],确保了决策的全面性和多样性。以人为本的伦理导向是参与式伦理规约的道德基础,确保技术发展和应用始终服务于人类利益,强调人应是决策和行动的中心,保障技术为人服务,而非反过来支配人类[16],以确保技术的发展与应用始终符合人的基本权利和尊严。

② 历史上,从康德的道德自律到萨特的存在主义选择论,均强调了人的理性在伦理行为中的独特作用。目前,人工智能等技术无法模仿人的复杂情感与道德理性,因此它们不能完全取代人在伦理规范制定及其批判性思考中的角色。人类的情感、同理心和对个体尊重的价值观,都是伦理决策中的基石,确保了伦理决策涵盖了比数据和逻辑更宽广的维度,如文化、道德情感等。参与式伦理规约强调了人在制定伦理规范和进行批判性思考中的主导地位,确保了人工智能技术的发展始终以人的价值为导向。

人工智能系统在设计、开发和应用过程中,始终将保护人的尊严、完整、自由、隐私和安全放在首位。人工智能应用应致力于消除技术应用中的歧视和偏见,提供均等的机会和资源,满足不同群体的需求。在人工智能系统的设计、开发和应用中,要坚持公平正义,杜绝任何形式的歧视和偏见。确保人工智能的发展始终在人的控制之下,避免技术失控造成危害。提高人工智能系统的透明度、可解释性和可控性,确保决策逻辑和行为后果可追溯、可验证。在人机协作中,要明确划分人机边界,避免人过度依赖技术、被技术所操控。人工智能系统必须尊重个人隐私,保障用户对个人信息的控制权和知情权;收集、使用个人数据要合法、正当,符合特定、明确的目的,不得过度收集或超范围使用;对敏感个人信息要严格保护,防止未经授权的披露、访问或滥用;在平衡个人隐私与公共利益时,要恪守必要性和最小化原则,并提供有效的隐私保护措施。人工智能的伦理责任需要社会各界共同承担;政府、企业、研究机构、公众等利益相关方都应参与到人工智能伦理规约的制定和实施中,明晰各自权利义务,形成多方协作、共同治理的机制。

3.2 基于参与式伦理规约的人工智能治理框架应明确多元主体参与的权利边界随着人工智能技术的发展和应用,多元主体包括个人、技术提供者、政府和企业等都在参与和影响技术的决策和实践。这种多元主体的参与带来了权利和责任的边界问题,需要明确界定并确保各主体的权益得到平衡和保护。在智能技术普及的背景下,技术提供者与用户之间的权利关系日益重要,尤其涉及数据所有权、访问权和使用权。用户生成的数据常被视作被技术提供者所有,因此需重新定义数据所有权,增强用户控制权;用户应能监督技术应用,要求透明度,并享有使用中的知识产权。

作为传统治理模式的转化和创新,参与式伦理规约提高了决策透明度,确保信息公开和可访问,并通过包容性的设计③鼓励不同背景主体的参与,集合多样视角提升决策质量和公众信任。在权利平衡方面,参与式伦理规约强调了个体权利与集体利益之间的协调。个人在享有隐私权、表达权和自主权的同时,也被赋予了在技术应用和数据处理中监督和提出质疑的权力。企业和技术提供者在追求创新和经济效益的过程中,同样需要承担起保护用户数据、确保算法公正和透明的责任。政府作为监管者,不仅要制定合理的政策和法规来引导技术发展,还要确保这些政策的执行能够平衡不同群体的利益,防止权力滥用,并在必要时进行干预以维护公共利益。在责任共担方面,参与式伦理规约明确了各主体在治理过程中的责任和义务,确保了任何决策和行为都有明确的责任主体和追责机制。这种权利与责任的平衡共担为智能社会治理的稳定和持续发展提供了有力保障。

③ 包容性设计是适用于所有人,是以“人”为中心出发点的设计。

3.3 “共建、共治、共享”是实现人工智能参与式伦理规约的关键目标“共建、共治、共享”的理念是落实人工智能参与式伦理规约的重要指导原则。通过构建多元参与、开放包容的伦理治理机制,厘清利益相关方责任边界,推动人工智能发展成果的广泛普惠,方能实现以人为本、惠及全人类的人工智能发展愿景。这需要政府、企业、社会组织、公众等各方共同努力,在参与中凝聚共识,在互动中创新治理,在实践中优化制度,持续推进人工智能治理体系和治理能力现代化。

“共建”强调多元主体的广泛参与。人工智能的影响涉及方方面面,单靠政府的自上而下管制难以全面应对。要搭建多元参与平台,鼓励不同群体表达诉求、贡献智慧,形成包容开放的协商机制。企业、学术界要积极参与伦理规约研究制定,将人文关怀融入技术设计之中。公众也要提升人工智能素养,主动参与伦理议题讨论。唯有凝聚各方共识,人工智能的发展方能贴近民意、体现民意。

“共治”强调多元主体的权责划分与协调配合。人工智能治理涉及伦理、法律、技术等多重维度,需要系统性的制度安排。政府要完善顶层设计,健全法律法规,为人工智能发展提供制度保障。企业要加强行业自律,将伦理要求内化为研发和经营行为准则。行业组织、第三方机构要发挥桥梁纽带作用,促进跨领域对话合作,探索柔性治理模式。多元共治格局的形成,有利于调动各方资源和力量,提升人工智能治理的整体效能。

“共享”强调人工智能发展成果的广泛惠及。人工智能是放大社会生产力、提升公共服务水平的重要工具,其发展应让全社会共同受益。要完善普惠机制,保障不同群体平等参与和获益的机会,防止技术成果被垄断、被滥用。要发挥人工智能在教育、医疗、民生等领域的优势,促进基本公共服务均等化。同时,要加强伦理教育和宣传引导,提升全民科技伦理素养,营造人工智能向善发展的社会环境。

4 人工智能参与式伦理规约的实践路径及趋向 4.1 人工智能时代面临诸多伦理风险挑战在智能化时代,数据与算法是人工智能应用的核心,其交互和依赖也引发多个伦理问题,特别是数据处理和算法设计中的公平、透明[17]和可靠性[18]等问题。在人工智能应用中,数据隐私和算法公平性是关键伦理议题。随着技术的进步,这些议题的复杂性和紧迫性也随之增加,迫切需要有效的解决方案。参与式伦理规约通过引入多元主体的观点和经验,可以更全面地识别和应对这些挑战。例如,在数据隐私问题上,可以组织用户代表、技术专家、法律专家和政策制定者共同讨论,制定既保护个人隐私又不阻碍技术创新的实施细则。

数据隐私已经演变成一个多维度、深层次的复杂议题,其范畴远超过了传统的个人信息保护。现代数据隐私不仅要关注信息的基本保护,还要涵盖数据的完整性、安全性、透明性,及相关算法的可解释性[19]。这要求在数据的获取、存储、传输和处理过程中都要实现充分的保护,以防数据被篡改或损坏,并确保算法的决策过程透明、可追溯。同时,个人对于他们的数据如何被使用应该有明确的控制权[20]。此外,对“个人信息”的定义④也在不断扩展,包括数字足迹如在线行为、购物习惯和搜索历史,甚至进一步涉及生物特征、情感和心理状态。这些都需要在数据隐私的讨论中被考虑。在参与式伦理规约框架下,可以通过定期举办公众论坛、专家研讨会等形式,持续更新对个人信息的定义和保护范围,确保相关政策和技术措施能够跟上数据应用的发展步伐。

④ 个人信息权利是一种私有的个体权利,包括姓名、活动轨迹、住址等信息。但是实际上,一部分个人信息并非私人拥有的。例如,姓名便属于需要公开的信息。

算法公平性则涉及算法决策过程中的偏见问题及其社会影响。理想情况下,算法应对所有参与者公正,但实际上,它们常基于含偏见的历史数据训练,可能无意中放大偏见,导致不公平决策。算法的复杂性和不透明性加大了检测和纠正这些偏见的难度。参与式伦理规约可以通过建立多元化的算法审核委员会,引入来自不同背景的专家和社会代表,定期评估算法的公平性,并提出改进建议。这种做法不仅能够及时发现潜在的偏见,还能促进算法设计者与社会各界的对话,提高算法的透明度和可解释性。

人工智能的决策不透明性带来了责任归属挑战。在传统情况下,责任归属于人的意图和行为,但在涉及高度自主的技术(如深度学习)时,机器决策的不透明性使责任界定复杂化。对于智能体的责任承担,近年来是伦理学界的一个争论点。一种观点是,责任应当归咎于开发这些系统的人。他们是为机器提供指导原则和训练数据的人,因此应当对机器的行为负责。另一种观点则认为,使用这些系统的人应当对其决策结果负责,因为他们选择了在特定情境中部署这些技术。此外,还有一种更为激进的观点,主张机器应当被视为伦理主体,因此应当对其自身的决策负责[21]。从这一角度来看,或许随着技术的进一步发展,对于责任一词的概念也会被重新定义。这不仅是因为技术的复杂性,还因为人工智能技术正在改变我们对自主性、意图和责任的基本理解。

人工智能特性引发法律框架的适配风险。人工智能的特性,如自主性、预测性和不透明性,给法律框架带来挑战。如何界定机器学习决策系统的“过失”或“意图”,以及当算法导致歧视或偏见时责任的确定,都需要法律框架的深入反思和调整。现有法律需适应人工智能的特性,同时在确定责任时考虑技术设计和使用者。这要求法律框架不仅要具有灵活性和适应性,以应对技术快速变化,还需要重新审视基本法律原则和概念。

为了构建完善的治理体系,需正确理解伦理与法律的关系并明确二者界限。伦理关注行为的道德性,提供关于正确行为的指导,而法律则界定行为的合法范围。两者在人工智能应用中可能产生冲突,如某算法可能在法律上合法,但在伦理上被视为不当。随着对人工智能伦理问题的关注加强,法律制定开始考虑融入伦理原则,促成“法律的伦理化”;伦理原则可以为法律制定提供指导,帮助法律制定者理解新技术带来的挑战和伦理问题,制定合适的法律规定以应对这些问题。

4.2 构建多元主体参与的多层次人工智能伦理规范体系是面向未来的必然抉择为有效应对挑战,引导我国人工智能产业健康、有序发展,亟待不断完善政策法规,构建一个系统化、科学的人工智能伦理规范体系,以促进人工智能技术的伦理发展。

(1)建立多层次参与式立法机制。在人工智能快速发展的背景下,传统的自上而下立法模式已难以适应技术变革和社会需求的复杂性。为确保中国“人工智能法”⑤等相关法律法规的制定能充分反映多元主体的利益,并具备足够的前瞻性和灵活性,建议建立多层次参与式立法机制,强调通过理性对话达成共识[22]。人工智能领域高度专业化且影响广泛,多元主体共同参与,其治理更需要多利益相关方的协作方法[23]。这种多层次参与式立法机制有助于制定更合理、更有效的法律法规。吸收各方智慧,平衡不同利益,让公众更理解、认同。但多层次的参与式立法机制,也面临一些挑战:如何确保参与者代表性、如何弥补普通公众专业知识不足,以及如何有效整合各种意见[24]。这些问题需要在实践中不断摸索、完善。只有克服这些挑战,发挥参与式立法优势,才能为人工智能健康发展提供有力法律保障。

⑤ 目前我国尚未针对人工智能立法,《中华人民共和国数据安全法》《中华人民共和国个人信息保护法》《中华人民共和国网络安全法》《互联网信息服务算法推荐管理规定》《生成式人工智能服务管理暂行办法》等法律法规从多方面对人工智能进行了约束,但形成一部有针对性、完善的“人工智能法”仍然是十分必要的。2024年3月16日发布的《人工智能法(学者建议稿)》成为人工智能立法的重要一步。

(2)构建动态调整的人工智能伦理评估体系。人工智能技术发展迅速,其应用场景不断拓展,相应的伦理问题也日益复杂。传统的静态评估方法难以适应这种变化,需要一个能够动态调整的伦理评估体系,及时应对新出现的伦理挑战。人工智能伦理评估应该是一个持续的、反思性的过程[25];这种动态评估不仅能够识别当前的伦理风险,还能预测潜在的伦理问题,为人工智能的负责任发展提供指导。构建这样一个体系,应考虑设立由多方利益相关者组成的伦理评估委员会,定期审查和更新评估标准。开发开源的人工智能伦理评估工具,允许公众参与测试和改进。建立评估结果公示制度,接受社会监督。同时,还应该建立快速响应机制,及时处理在人工智能应用中出现的新伦理问题。这种动态调整的评估体系能够确保我们的伦理标准始终与技术发展和社会需求保持同步,为人工智能的健康发展提供持续的伦理指导。

(3)加强伦理教育培训,促进国内外交流合作。美国和英国等国家高度重视人工智能伦理教育。美国高校普遍开设人工智能伦理相关课程,将伦理教育纳入人才培养体系;政府资助开发在线课程、教学案例等教育资源,鼓励跨学科培养具备伦理视野的复合型人才。英国政府提出“负责任的人工智能教育”倡议,支持高校开设人工智能伦理必修课;其在相关专业教学中融入伦理内容,并为在职人员提供伦理培训项目,提升职业操守和伦理决策能力。我国应借鉴相关做法,在高等院校全面开设人工智能伦理相关必修课程,将伦理训练贯穿人工智能人才培养全过程,培养具备扎实专业知识和良好伦理素养的复合型人才;制定并实施人工智能从业人员职业伦理教育培训计划,提升相关领域工作人员的伦理决策和实践能力;定期举办人工智能伦理论坛、研讨会等活动,促进产学研用各界的交流合作。

(4)引入“沙盒机制”进行法规试点。人工智能技术的发展速度远超传统立法程序,这使得相关法规常常落后于实际需求。为解决这一问题,可以借鉴金融科技领域的“监管沙盒”概念,在人工智能领域引入“沙盒机制”进行法规试点。这种机制允许在特定范围内,暂时放宽某些监管要求,为创新技术提供一个受控的实验环境。在促进创新的同时保护消费者权益和市场稳定[26]。在人工智能领域实施“沙盒机制”,可以选择特定地区或行业进行试点,允许企业在一定程度上突破现有法规限制,测试新的人工智能应用。同时,监管部门可以近距离观察这些应用的实际效果和潜在风险,及时调整监管策略。这种方法不仅可以加速法规的制定和完善,还能为全面推广积累宝贵的实践经验。但也需要注意平衡创新与风险之间的关系,确保“沙盒”不会成为规避监管的工具。通过审慎实施“沙盒机制”,有望建立一个更加灵活、适应性强的人工智能监管体系。

5 结语总之,人工智能以前所未有的速度进入社会各个领域,如何在保持创新活力的同时,确保技术的公平、公正与透明,始终是伴随发展不断思考的伦理问题。参与式伦理规约,强调了多方利益相关者的共同参与,以及伦理原则在技术发展全过程中的实践与体现。参与式伦理规约的实践需要在制度、机制和文化等多个层面进行深入的探讨和改革,持续推动多方利益相关者的深度合作,加强伦理原则在人工智能发展中的实践,以实现人工智能与人类社会的和谐共生,实现人工智能的可持续发展,推动人类文明的进步。

| [1] |

Ward S J A, Wasserman H. Towards an open ethics: Implications of new media platforms for global ethics discourse. Journal of Mass Media Ethics, 2010, 25(4): 275-292. DOI:10.1080/08900523.2010.512825 |

| [2] |

利尔·亚当. 未来的夏娃. 李颦儿, 闭朝莲, 译. 北京: 北京理工大学出版社, 2013. Adam V. The Future Eve. Translated by Li P E, Bi Z L. Beijing: Beijing Institute of Technology Press, 2013. (in Chinese) |

| [3] |

艾萨克·阿西莫夫. 我, 机器人. 叶李华, 译. 江苏: 江苏凤凰文艺出版社出版, 2013. Asimov I. I, Robot. Translated by Ye L H. Jiangsu: Jiangsu Phoenix Literature and Art Publishing House, 2013. (in Chinese) |

| [4] |

赵梓羽. 生成式人工智能数据安全风险及其应对. 情报资料工作, 2024, 45(2): 30-37. Zhao Z Y. Data security risks and countermeasures of generative artificial intelligence. Information and Documentation Services, 2024, 45(2): 30-37. (in Chinese) |

| [5] |

杨建军. 数字治理的法治进路. 比较法研究, 2023, (5): 1-19. Yang J J. Legal approach to digital governance. Journal of Comparative Law, 2023, (5): 1-19. (in Chinese) |

| [6] |

余雅风, 王朝夷. 由技术伦理向法律规范演进: 国外人工智能应用规范研究综述. 河北法学, 2023, 41(2): 83-101. Yu Y F, Wang C Y. Evolution from ethics to law: A foreign literature review of research on regulations of artificial intelligence. Hebei Law Science, 2023, 41(2): 83-101. (in Chinese) |

| [7] |

Ryan M. In AI we trust: Ethics, artificial intelligence, and reliability. Science and Engineering Ethics, 2020, 26(5): 2749-2767. DOI:10.1007/s11948-020-00228-y |

| [8] |

Cornwall A. Unpacking 'Participation': Models, meanings and practices. Community Development Journal, 2008, 43(3): 269-283. DOI:10.1093/cdj/bsn010 |

| [9] |

Malone R E, Yerger V B, McGruder C, et al. "It's like Tuskegee in reverse": A case study of ethical tensions in institutional review board review of community-based participatory research. American Journal of Public Health, 2006, 96(11): 1914-1919. DOI:10.2105/AJPH.2005.082172 |

| [10] |

张成岗. 人工智能的社会治理: 构建公众从"被负责任"到"负责任"的理论通道. 中国科技论坛, 2019, (9): 1-4. Zhang C G. Social governance of artificial intelligence: Constructing a theoretical Evolution from ethics to law: A foreign literature review of research on regulations of artificial intelligence. Forum on Science and Technology in China, 2019, (9): 1-4. (in Chinese) |

| [11] |

张成岗. 走向"智治"时代以科技创新推动社会治理现代化. 国家治理, 2020, (14): 8-11. Zhang C G. Towards the era of "intellectual governance" and promoting the modernization of social governance with scientific and technological innovation. Governance, 2020, (14): 8-11. (in Chinese) |

| [12] |

Dahlberg L. The Internet and democratic discourse: Exploring the prospects of online deliberative forums extending the public sphere. Information, Communication & Society, 2001, 4(4): 615-633. |

| [13] |

张成岗, 王宇航. 社会治理的技术逻辑: 源流、特征及趋向. 江苏行政学院学报, 2021, (6): 61-66. Zhang C G, Wang Y H. Technical logic of social governance: Origin, characteristics and trend. The Journal of Jiangsu Administration Institute, 2021, (6): 61-66. (in Chinese) |

| [14] |

弗朗西斯·福山. 我们的后人类未来: 生物技术革命的后果. 黄立志, 译. 桂林: 广西师范大学出版社, 2017. Fukuyama F. Our Posthuman Future: Consequences of the Biotechnology Revolution. Translated by Huang L Z. Guilin: Guangxi Normal University Press, 2017. (in Chinese) |

| [15] |

江怡. 对人工智能与自我意识区别的概念分析. 自然辩证法通讯, 2019, 41(10): 1-7. Jiang Y. A conceptual analysis of the distinction between artificial intelligence and self-consciousness. Journal of Dialectics of Nature, 2019, 41(10): 1-7. (in Chinese) |

| [16] |

Xu W. Toward human-centered AI: A perspective from human-computer interaction, Interactions, 2019, 26(4): 42-46.

|

| [17] |

杨建军. 数字治理的法治进路. 比较法研究, 2023, (5): 1-19. Yang J J. Legal approach to digital governance. Journal of Comparative Law, 2023, (5): 1-19. (in Chinese) |

| [18] |

陈升, 刘子俊, 张楠. 数字时代生成式人工智能影响及治理政策导向. 科学学研究, 2024, 42(1): 10-20. Chen S, Liu Z J, Zhang N. Generative artificial intelligence impacts and governance policy orientation in the digital age. Studies in Science of Science, 2024, 42(1): 10-20. (in Chinese) |

| [19] |

张欣. 生成式人工智能的数据风险与治理路径. 法律科学(西北政法大学学报), 2023, 41(5): 42-54. Zhang X. Data risks and governance pathways of generative artificial intelligence. Science of Law (Journal of Northwest University of Political Science and Law), 2023, 41(5): 42-54. (in Chinese) |

| [20] |

申卫星, 李夏旭. 个人数据所有权的赋权逻辑与制度展开. 法学评论, 2023, 41(5): 114-128. Shen W X, Li X X. The entitlement logic and institutional design of personal data ownership. Law Review, 2023, 41(5): 114-128. (in Chinese) |

| [21] |

宋春艳, 李伦. 人工智能体的自主性与责任承担. 自然辩证法通讯, 2019, 41(11): 95-100. Song C Y, Li L. The autonomy and responsibility bearing of the artificial intelligent agent. Journal of Dialectics of Nature, 2019, 41(11): 95-100. (in Chinese) |

| [22] |

Habermas J. Between Facts and Norms: Contributions to a Discourse Theory of Law and Democracy. Cambridge: MIT Press, 1996.

|

| [23] |

Cath C, Wachter S, Mittelstadt B, et al. Artificial intelligence and the 'good society': The US, EU, and UK approach. Science and Engineering Ethics, 2018, 24(2): 505-528. |

| [24] |

Fung A. Varieties of participation in complex governance. Public Administration Review, 2006, 66: 66-75. |

| [25] |

Floridi L, Cowls J, Beltrametti M, et al. AI4People—An ethical framework for a good AI society: Opportunities, risks, principles, and recommendations. Minds and Machines, 2018, 28(4): 689-707. |

| [26] |

Zetzsche D A, Buckley R P, Arner D W, et al. Regulating a revolution: From regulatory sandboxes to smart regulation. Fordham Journal of Corporate & Financial Law, 2017, 23: 31-103. |